原始论文:Algorithms for Non-negative Matrix Factorization - Daniel D.Lee、H. Sebastian Seung

问题描述

传统的非负矩阵分解(Non-negative matrix factorization, NMF)问题可以描述如下:

对于给定的一个非负矩阵V∈R+n×m,将其分解为非负矩阵W∈R+n×d 和非负矩阵H∈R+d×m 的乘积,即V=W⋅H。

事实上,上式中的等号很难成立(目前已有的解法得不到精确解),所以 W 和 H 相乘只能尽量逼近 V,即V≈WH=V~。

非负矩阵分解可理解为:原始矩阵V 的列向量是通过W 中所有列向量加权求和得到的,而权重系数就是H 对应列向量的元素。因此称W 为基矩阵,H 为系数矩阵。

一般情况下d 的选择要比m,n 小得多,即满足d≪min(m,n) ,通常要求(m+n)d<mn。

从数据科学的角度出发,非负矩阵V 代表着样本数是m 的样本,每个样本的特征数(维度)是n。通过 NMF 我们就可以利用基矩阵W 代替原始矩阵,从而实现降维(降到了d 维),同时也实现了对原始数据的特征提取,这减少了存储空间和计算机资源。

这种分解有利于发现潜在的特征和模式,因为非负性能够保持数据的可加性和解释性,从而在多个应用域中有着重要的意义。

求解方法

NMF的求解实际上就是一个最优化问题,而且是一个NP问题。其目标函数根据不同的假设也有很多种不同的定义,其中应用最广泛的是欧氏距离和 KL散度。

欧氏距离

假设噪声矩阵E=V−V~=V−WH 服从于高斯分布,那么最大化其似然函数就等价于最小化V 和V~ 之间的欧氏距离。矩阵的欧氏距离在数学上可以用 Frobenius范数 表示,定义为矩阵所有元素的平方和。

Frobenius范数的优化目标形式化为:

J(W,H)=W,Hmin∥V−WH∥F2=W,Hmini,j∑(vij−(WH)ij)2

其中,下标F 表示Frobenius范数,vij 是矩阵V 中的元素,而(WH)ij 是矩阵乘积WH 中的元素。

KL散度

如果噪声矩阵服从于泊松分布,那么损失函数正好是KL散度:

J(W,H)=W,HminKL(V∣∣WH)=W,Hmini,j∑(vijlog(WH)ijvij−vij+(WH)ij)

其中KL(⋅∣∣⋅) 表示 Kullback-Leibler 散度。

梯度下降修正

根据梯度下降法的思想,为了最小化损失函数,我们很容易得出,应该在每步迭代时计算损失函数J(W,H) 关于W 和H 的梯度:

∇WJ=∂W∂J,∇HJ=∂H∂J

然后使用下面的规则对其进行更新:

WH←W−μ∇WJ,←H−η∇HJ

其中μ,η 是学习率,用于控制每次迭代中参数更新的步长。

利用梯度下降法求解NMF问题固然有效,但存在一个关键问题是难以保证更新后的W 和H 仍然满足非负条件,并且还要选择合适的学习率来调整算法的收敛性能。

实际上,我们可以通过设计学习率的表达式来修正这个问题。为了方便展示,我们将梯度下降法从上面提到的矩阵形式写成元素形式:

wik←wik−μik∂wik∂J(W,H)hkj←hkj−ηkj∂hkj∂J(W,H)

如何是以Frobenius范数作为目标函数,则:

∂wik∂J(W,H)∂hkj∂J(W,H)=−[(V−WH)H⊤]ik=−[W⊤(V−WH)]kj

由于非负矩阵的乘积还是非负矩阵,我们可以调整学习率从而将梯度下降法变为乘法算法。令:

μik=[WHH⊤]ikwik,ηkj=[W⊤WH]ikhkj

最终更新公式可写为:

wikhkj←wik[WHH⊤]ik[VH⊤]ik←hkj[W⊤WH]kj[W⊤V]kj

收敛性证明可以参考:Lee D D, Seung H S. Algorithms for Non-negative Matrix Factorization[C]// NIPS. 2000:556–562.

拉格朗日数乘

另一个更朴素的想法是通过拉格朗日乘子法应对这种有约束的优化问题。

W,Hmin∥V−WH∥F2s.t.W∈R+,H∈R+

其无约束的对偶拉格朗日函数为:

L=i=1∑mj=1∑n(vij−k=1∑dwikhkj)2−i=1∑mk=1∑dλikwik−k=1∑dj=1∑nλkjwkj

分别求导,利用 KKT 互补松弛条件 blabla

非负矩阵分解(NMF)迭代公式推导证明 - 知乎 (zhihu.com)

交替最小二乘

由于ALS在每一步都能保证成本函数的单调递减,所以它通常具有较好的收敛性。但是,需要注意的是,因为NMF问题是非凸的,数学上ALS并不能保证找到全局最优解,它可能会收敛到局部最优。此外,这种方法对初始值敏感,不同的初始化可能会导致不同的结果。

待更:https://www.cnblogs.com/xingshansi/p/6679325.html

sklearn实现

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

| from sklearn.decomposition import NMF

nmf = NMF(n_components=2,

init=None,

solver='cd',

beta_loss='frobenius',

tol=1e-4,

max_iter=200,

random_state=None,

alpha=0.,

l1_ratio=0.,

verbose=0,

shuffle=False

)

W = nmf.fit_transform(X)

H = nmf.components_

err = nmf.reconstruction_err_

errs = nmf.residuals_

|

与PCA的区别

虽然NMF和PCA都用于降维和特征提取,但它们的基本假设,约束和应用有所不同。

假设和约束

- 非负性约束: NMF 的基矩阵和系数矩阵具有非负性约束。此约束使 NMF 特别适用于无法用负值准确表示的数据,例如图像和文本数据。

- 正交性与非负性: PCA寻求最大化方差的正交基(主成分),而NMF旨在找到模式的加性非负组合。这种约束差异导致了NMF中包含了可加性的特征部分的表示,而PCA中的则是原数据总体的表示。通常用于降噪、可视化和压缩。在对数据的固有结构没有明确的先验知识时比较有用。

可解释性

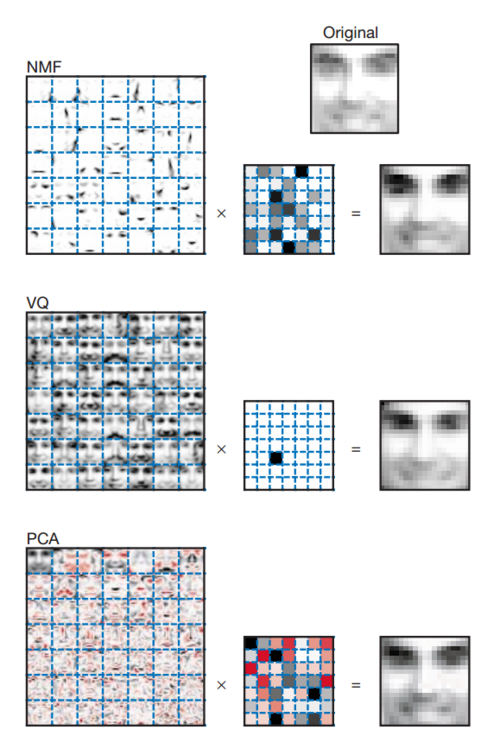

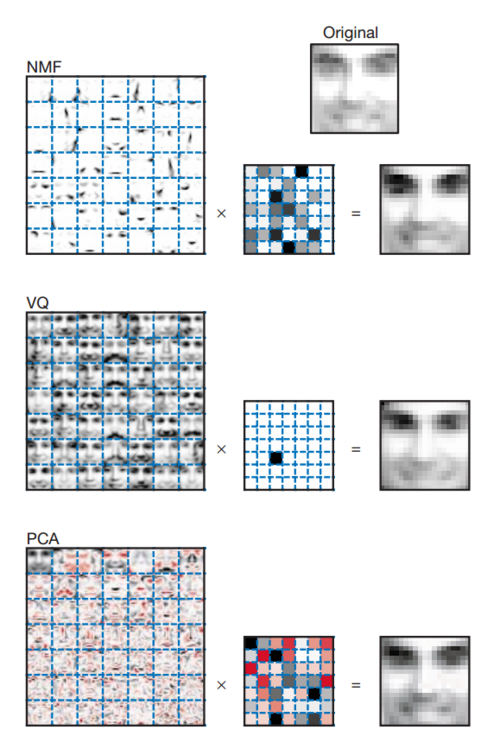

通过上图中的面部特征提取的例子,我们得以领略NMF处理数据的方式。

最左边的大矩阵由一系列的小图组成,这些小图是分析数据库中包含的2429个人脸图像的结果,每幅图像由19×19个像素组成。

传统方法(VQ分解)中这样的小图是一幅完整的人脸图像,但是在NMF方法中,每个小图是通过一组基图像乘以一个权重矩阵而产生的面部特征图,经过这样处理的每幅小图像恰好表示了诸如“鼻子”、“嘴巴”、“眼睛”等人脸局部概念特征,这便大大压缩了存放的图像数据量。

事实上Lee和Seung在他们的论文中更深入地指出,与人类识别事物的过程相似,NMF也是一种优化的机制,近似于我们的脑分析和存储人脸数据的过程。这个例子中,原图像表示这些局部特征的加权组合,这与人类思维中“局部构成整体”的概念是相吻合的。因此,NMF算法似乎体现了一种智能行为。

附:收敛唯一性证明

Lee D D, Seung H S. Algorithms for Non-negative Matrix Factorization[C]// NIPS. 2000:556–562.

待更:http://www.xiongfuli.com/机器学习/2016-01/NMF.html

参考

- 非负矩阵分解(NMF)迭代公式推导证明 - 知乎

- 【机器学习】NMF(非负矩阵分解)-CSDN博客

- 非负矩阵分解(3):拉格朗日乘子法求解 - LeeLIn

- Non-negative matrix factorization (NMF) vs Principal Component Analysis (PCA)

- 非负矩阵分解 - 熊伏枥个人空间

- 文本主题模型之非负矩阵分解(NMF) - 刘建平Pinard - 博客园 (cnblogs.com)